Gli errori sono deviazioni dei risultati della misurazione dal valore reale di una quantità. Il valore effettivo può essere stabilito solo eseguendo numerose misurazioni. In pratica, questo è impossibile da implementare.

Per l'analisi delle deviazioni, il valore più vicino al valore reale è considerato il valore effettivo del valore misurato. Si ottiene utilizzando strumenti e metodi di misura di alta precisione. Per comodità delle misurazioni, per garantire la possibilità di eliminare le deviazioni, vengono utilizzate diverse classificazioni degli errori. Considera i gruppi principali.

Metodo di espressione

Se classifichiamo gli errori degli strumenti di misura su questa base, possiamo distinguere:

- Deviazioni assolute. Sono espressi in unità della quantità misurata.

- Deviazione relativa. È espresso dal rapporto tra l'errore assoluto e il risultato della misurazione o il valore effettivo della quantità misurata.

- Deviazione ridotta. È l'errore relativo espressoil rapporto tra la deviazione assoluta dello strumento di misura e il valore preso come indicatore costante sull'intero campo della misura corrispondente. La sua scelta si basa su GOST 8.009-84.

Per molti strumenti di misura viene stabilita una classe di precisione. L'errore dato viene introdotto perché il valore relativo caratterizza la deviazione solo in un punto specifico della scala e dipende dal parametro del valore misurato.

Condizioni e fonti

Le deviazioni principali e aggiuntive si distinguono nella classificazione degli errori secondo questi criteri.

I primi sono gli errori degli strumenti di misura in normali condizioni di utilizzo. Le principali deviazioni sono dovute all'imperfezione della funzione di conversione, all'imperfezione delle proprietà dei dispositivi. Riflettono la differenza tra la funzione di conversione effettiva del dispositivo in condizioni normali e quella nominale (stabilita nei documenti normativi (condizioni tecniche, norme, ecc.)).

Ulteriori errori si verificano quando un valore devia dal valore della norma o per andare oltre i confini dell'area normalizzata.

Condizioni normali

I seguenti parametri normali sono definiti nella documentazione normativa:

- Temperatura dell'aria 20±5 gradi

- Umidità relativa 65±15%.

- Tensione di rete 220±4, 4 V.

- Frequenza di alimentazione 50±1Hz.

- Nessun campo magnetico o elettrico.

- La posizione orizzontale del dispositivo con una deviazione di ±2 gradi.

Classe di precisione

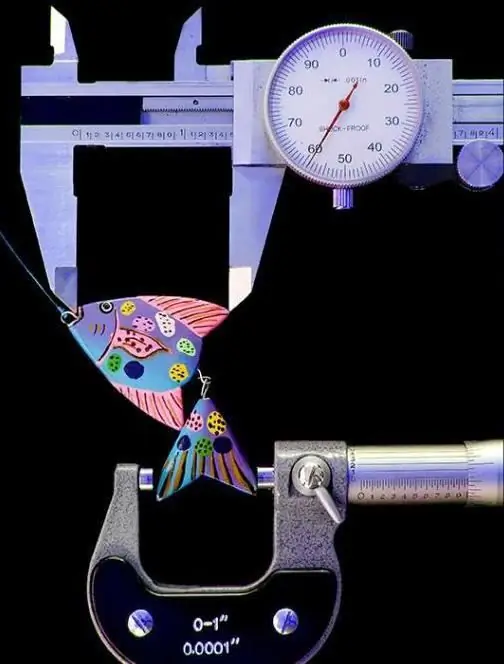

I limiti di tolleranza delle deviazioni possono essere espressi in errore relativo, assoluto o ridotto. Per poter scegliere lo strumento di misura più adatto, viene effettuato un confronto in base alla loro caratteristica generalizzata: la classe di precisione. Di norma, è il limite delle deviazioni di base e aggiuntive consentite.

La classe di precisione permette di comprendere i limiti degli errori di uno stesso tipo di strumenti di misura. Tuttavia, non può essere considerato un indicatore diretto dell'accuratezza delle misurazioni effettuate da ciascuno di tali strumenti. Il fatto è che anche altri fattori (condizioni, metodo, ecc.) influenzano la classificazione degli errori di misurazione. Questa circostanza deve essere presa in considerazione quando si sceglie uno strumento di misura in base alla precisione specificata per l'esperimento.

Il valore della classe di precisione si riflette nelle condizioni tecniche, negli standard o in altri documenti normativi. Il parametro richiesto viene selezionato dalla gamma standard. Ad esempio, per i dispositivi elettromeccanici, sono considerati normativi i seguenti valori: 0, 05, 0, 1, 0, 2, ecc.

Conoscendo il valore della classe di precisione dello strumento di misura, è possibile trovare il valore consentito della deviazione assoluta per tutte le parti del campo di misura. L'indicatore viene solitamente applicato direttamente alla scala del dispositivo.

La natura del cambiamento

Questa funzione viene utilizzata nella classificazione degli errori sistematici. Queste deviazioni rimangonocostante o cambia in base a determinati schemi durante l'esecuzione delle misurazioni. Assegna in questa classificazione e tipi di errori che hanno un carattere sistematico. Questi includono: deviazioni strumentali, soggettive, metodologiche e di altro tipo.

Se l'errore sistematico si avvicina a zero, questa situazione è chiamata correttezza.

Nella classificazione degli errori di misura in metrologia si distinguono anche le deviazioni casuali. Il loro verificarsi non può essere previsto. Gli errori casuali non sono responsabili; non possono essere esclusi dal processo di misurazione. Gli errori casuali hanno un impatto significativo sui risultati della ricerca. Le deviazioni possono essere ridotte mediante misurazioni ripetute con successiva elaborazione statistica dei risultati. In altre parole, il valore medio ottenuto da manipolazioni ripetute sarà più vicino al parametro reale rispetto a quello ottenuto da una singola misurazione. Quando la deviazione casuale è prossima allo zero, si parla di convergenza degli indicatori del misuratore.

Un altro gruppo di errori nella classifica - mancati. Sono associati, di regola, a errori commessi dall'operatore o non contabilizzati per l'influenza di fattori esterni. Gli errori sono generalmente esclusi dai risultati della misurazione, non presi in considerazione durante l'elaborazione dei dati ricevuti.

Dipende dalla magnitudo

La deviazione potrebbe non dipendere dal parametro misurato o essere ad esso proporzionale. Di conseguenza, nella classificazione degli errori in metrologia, additivo edeviazioni moltiplicative.

Questi ultimi sono anche indicati come errori di sensibilità. Di solito compaiono deviazioni aggiuntive dovute a pickup, vibrazioni nei supporti, attrito e rumore. L'errore moltiplicativo è associato all'imperfezione della regolazione delle singole parti degli strumenti di misura. A sua volta, può essere causato da vari motivi, tra cui l'obsolescenza fisica e l'obsolescenza delle apparecchiature.

Normalizzazione delle caratteristiche

Viene eseguito a seconda di quale deviazione è significativa. Se l'errore additivo è significativo, il limite viene normalizzato sotto forma di una deviazione ridotta, se è moltiplicativo, viene utilizzata la formula per l'entità relativa del cambiamento.

Questo è un metodo di normalizzazione in cui entrambi gli indicatori sono commensurabili, ovvero il limite della differenza principale ammissibile è espresso in una formula a due termini. Pertanto, l'indicatore della classe di precisione è composto anche da 2 numeri c e d in percentuale, separati da una barra. Ad esempio, 0,2/0,01 Il primo numero riflette l'errore relativo in condizioni normali. Il secondo indicatore caratterizza il suo aumento con un aumento del valore di X, cioè riflette l'influenza dell'errore additivo.

Dinamica dei cambiamenti nell'indicatore misurato

In pratica, viene utilizzata la classificazione degli errori, che riflette la natura dei cambiamenti nella quantità misurata. Implica la separazione delle deviazioni:

- A statico. Tali errori sorgono quando si misura lentamente cambiando onon cambia affatto.

- Dinamico. Appaiono quando si misurano quantità fisiche che cambiano rapidamente nel tempo.

La deviazione dinamica è dovuta all'inerzia del dispositivo.

Caratteristiche della stima delle deviazioni

Gli approcci moderni all'analisi e alla classificazione degli errori si basano su principi che garantiscono il rispetto dei requisiti per l'uniformità delle misurazioni.

Per raggiungere gli obiettivi di valutazione e ricerca, lo scostamento viene descritto utilizzando un modello (casuale, strumentale, metodologico, ecc.). Definisce le caratteristiche che possono essere utilizzate per quantificare le proprietà dell'errore. Nel corso dell'elaborazione delle informazioni è necessario trovare stime di tali caratteristiche.

Il modello viene scelto tenendo conto dei dati sulle sue fonti, comprese quelle ottenute durante l'esperimento. I modelli si dividono in non deterministici (casuali) e deterministici. Questi ultimi, rispettivamente, sono adatti per deviazioni sistematiche.

Il modello generale per l'errore casuale è il valore che implementa la funzione di distribuzione di probabilità. Le caratteristiche di deviazione in questo caso sono divise in intervallo e punto. Quando si descrive l'errore dei risultati della misurazione, vengono solitamente utilizzati i parametri di intervallo. Ciò significa che i limiti entro i quali può essere collocata la deviazione sono definiti corrispondenti ad una certa probabilità. In una situazione del genere, i limiti sono chiamati confidenza e la probabilità, rispettivamente, confidenza.

Le caratteristiche dei punti vengono utilizzate nei casi in cui non vi è alcuna necessità o possibilità di stimare i limiti di confidenza della deviazione.

Principi di valutazione

Quando si scelgono le stime di deviazione, vengono utilizzate le seguenti disposizioni:

- Vengono caratterizzati i singoli parametri e le proprietà del modello selezionato. Ciò è dovuto al fatto che i modelli di deviazione hanno una struttura complessa. Molti parametri sono usati per descriverli. La loro determinazione è spesso molto difficile e in alcune situazioni persino impossibile. Inoltre, in molti casi, la descrizione completa del modello contiene informazioni ridondanti, mentre la conoscenza delle caratteristiche individuali sarà sufficiente per implementare i compiti e raggiungere gli obiettivi dell'esperimento.

- Le stime delle deviazioni sono determinate approssimativamente. L'accuratezza delle caratteristiche è coerente con lo scopo delle misurazioni. Ciò è dovuto al fatto che l'errore caratterizza solo la zona di incertezza del risultato e la sua accuratezza finale non è necessaria.

- È meglio esagerare che sottovalutare la deviazione. Nel primo caso la qualità della misura diminuirà, nel secondo caso è probabile il completo deprezzamento dei risultati ottenuti.

Stima gli errori prima o dopo la misurazione. Nel primo caso si chiama a priori, nel secondo - a posteriori.